올라마(Ollama)는 로컬 환경에서 여러 대규모 언어 모델(LLM)을 실행할 수 있도록 지원하는 오프소스 도구이다. REST API로 모델을 서빙할 수도 있다. 확장 기능을 사용하면 챗GPT와 유사한 웹 UI를 구현해 사용할 수도 있다. 윈도우 환경에서 올라마를 설치하고 라마3(llama3 모델을 실행하는 방법에 대해 알아보자.

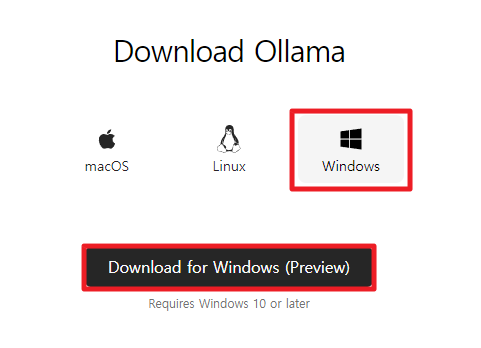

올라마(Ollama) 설치

올라마 다운로드 페이지에 접속 후 윈도우 프리뷰(Windows Preview)를 다운로드한다.

라마3(llama3) 모델 실행

올라마 모델 페이지에 접속해 사용할 모델을 선택할 수 있다. 라마3(llama3) 모델을 사용해보자. 다른 모델도 실행 방법이 동일하다. CMD에서 다음 명령어를 입력하면 라마3 모델을 자동으로 다운로드 후 이를 실행한다. 다운로드 된 모델 파일은 ‘C:/Users/사용자명/.ollama’ 경로에 위치한다.

- 라마3 모델 실행

ollama run llama3- 라마3 모델 종료

/bye모델을 API로 서빙

올라마 API 문서 페이지에 접속하면 위에서 실행한 라마3 모델을 REST API로 사용하는 방법에 대해 자세히 확인할 수 있다. 외부에서 API를 사용할 수 있도록 설정하는 방법과 Generate과 Chat API 사용 방법을 살펴보자.

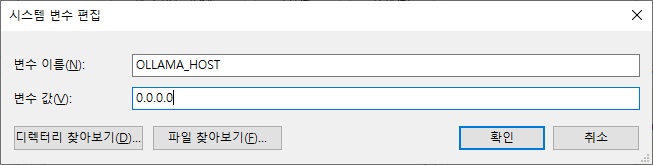

외부 접속 허용 설정

시스템 속성 – 환경 변수 – 시스템 변수 – 새로 만들기 클릭 후 변수 이름에 ‘OLLAMA_HOST’를 입력하고, 변수 값에 ‘0.0.0.0’을 입력하고 확인을 클릭한다.

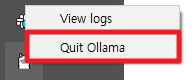

작업 표시줄에서 올라마 아이콘 우클릭 후 Quit Ollama를 클릭하여 실행 중인 Ollama를 종료한다.

CMD를 열어 다시 모델을 실행한다. 이렇게 하면 외부 환경에서도 API를 사용할 수 있다.

ollama run llama3Generate API 테스트

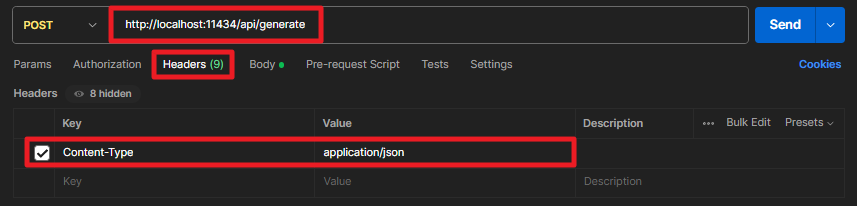

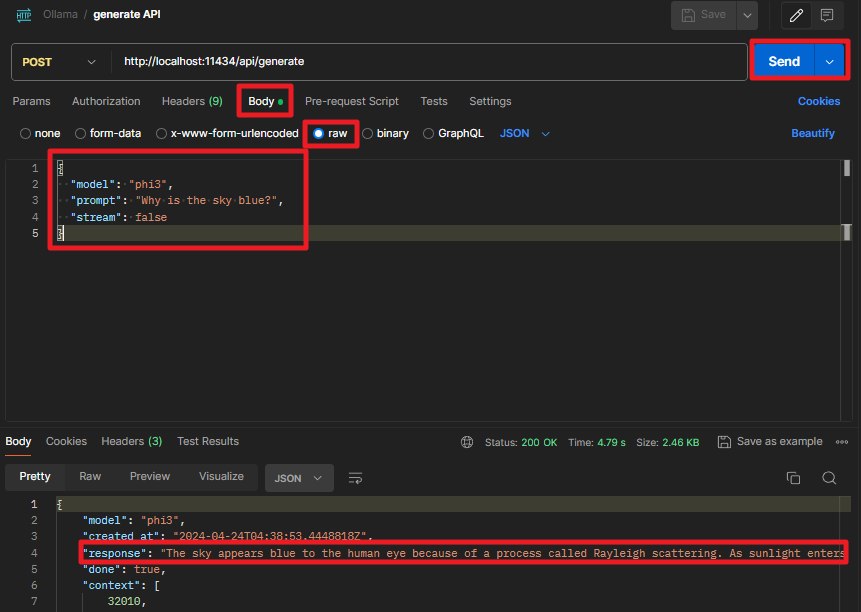

아래 조건으로 API를 호출하면 질문에 대한 응답을 얻을 수 있다.

- Method: POST

- Host: http://localhost:11434/api/generate

- Headers

- Content-Type : application/json

- Body – raw

{

"model": "phi3",

"prompt": "Why is the sky blue?",

"stream": false

}

Chat API 테스트

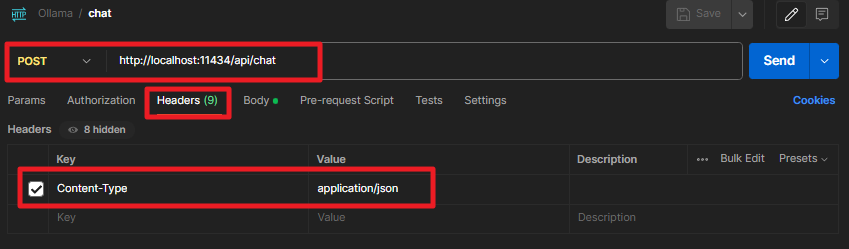

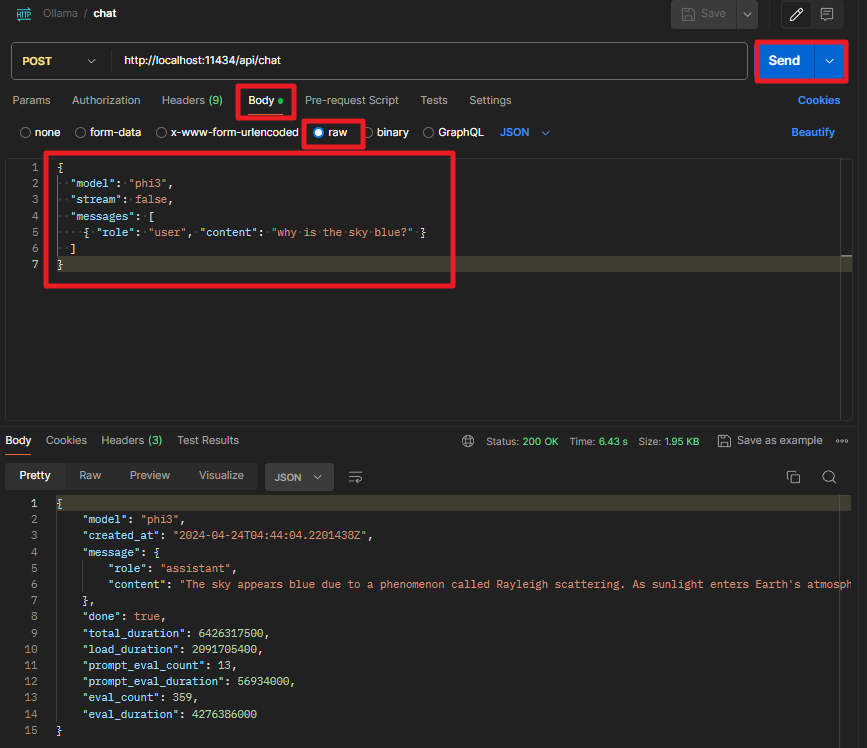

아래 조건으로 API를 호출하면 질문에 대한 응답을 얻을 수 있다.

- Method: POST

- Host: http://localhost:11434/api/chat

- Headers

- Content-Type : application/json

- Body – raw

{

"model": "phi3",

"stream": false,

"messages": [

{ "role": "user", "content": "why is the sky blue?" }

]

}

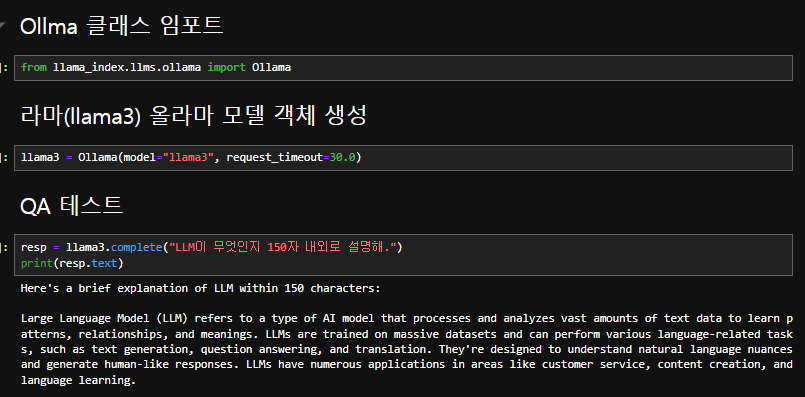

Llama-Index로 Ollama 모델 사용

파이썬 Llama-Index 프레임워크를 이용해 Ollama로 서빙하고 있는 모델을 사용할 수 있다.

Llama-Index 설치

CMD에서 다음 명령으로 llama-index를 설치한다.

pip install llama-indexLlama-Index Ollama 확장 설치

CMD에서 다음 명령으로 llama-index Ollama 확장을 설치한다.

pip install llama-index-llms-ollamaQA 테스트