NVIDIA Geforce RTX 3060 GPU를 윈도우 10에 설치하고, 오픈소스 AI 모델을 활용하기 위한 사전 준비 과정을 살펴보자. 먼저, 그래픽 드라이버, CUDA, cuDNN, 그리고 PyTorch를 차례대로 설치하는 방법을 알아보자. 이 모든 단계를 마쳐야만 GPU를 이용하여 HuggingFace 등에서 공개된 오픈소스 LLM 모델을 효과적으로 사용할 수 있다.

NVIDA 그래픽 드라이버 설치

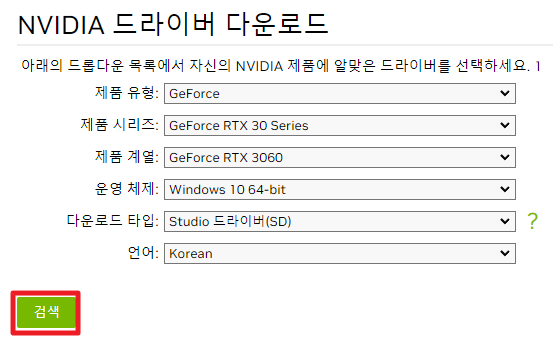

NVIDIA 드라이버 다운로드 사이트 접속하여 다음과 같이 옵션을 선택하고 검색 버튼을 클릭한다.

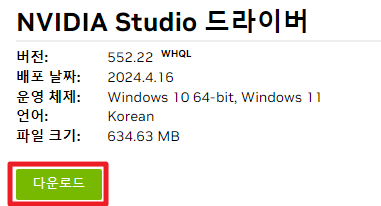

NVIDA Studio 드라이버 다운로드에서 다운로드 버튼을 클릭한다.

다운로드 버튼을 클릭한다.

- 설치 진행

다운로드한 설치 파일을 열어 설치 과정을 진행한다.

CUDA 설치

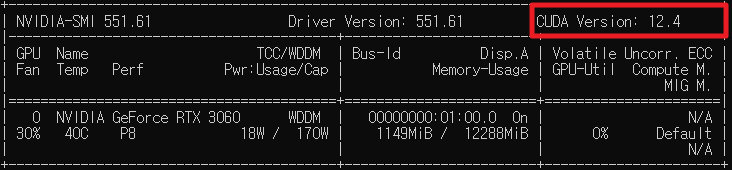

CMD에서 다음 명령을 입력한다. 권장 CUDA 버전을 확인한다. 이는 CUDA 권장 사항을 표시하는 것이지 해당 버전의 CUDA가 설치되어 있다는 뜻은 아니다.

nvidia-smi

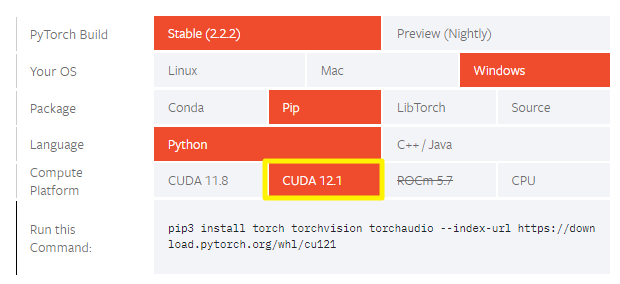

PyTorch 설치 가이드 접속에 접속해 CUDA 12.1 버전을 지원하는 것을 확인한다.

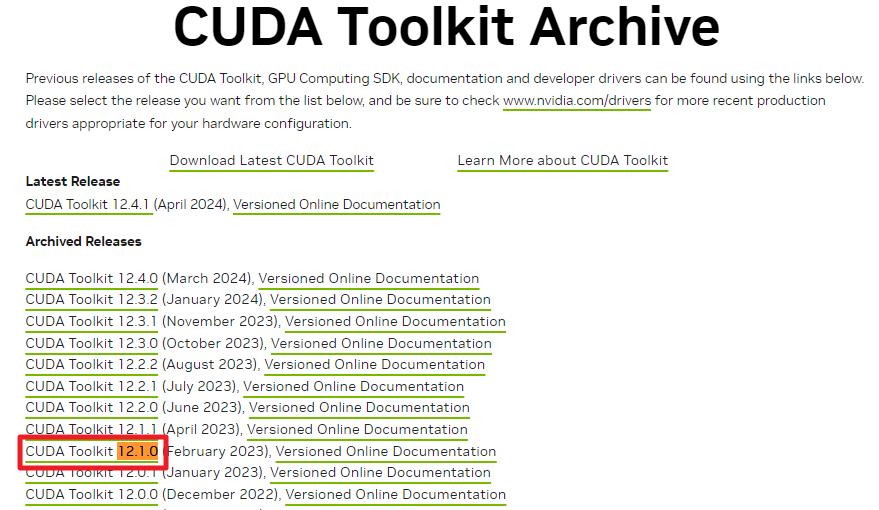

CUDA Toolkit Archive 접속 후 CUDA Toolkit 12.1.0를 선택한다.

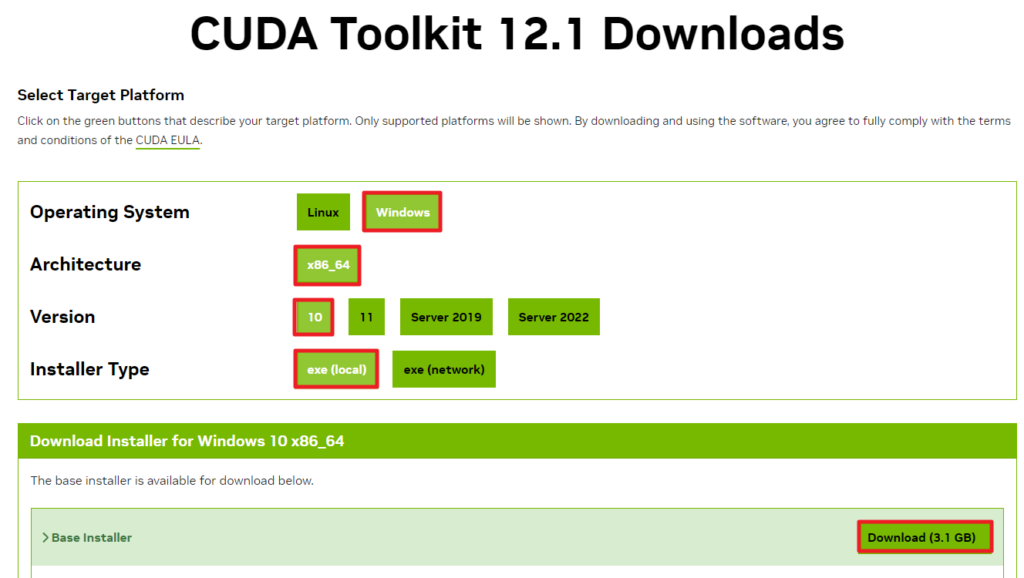

CUDA Toolkit 관련 옵션을 지정하고 다운로드 버튼을 클릭한다.

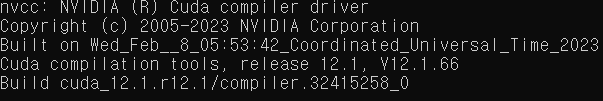

CMD에서 다음 명령을 입력해 쿠다가 정상적으로 설치되었는지 확인한다.

nvcc --version

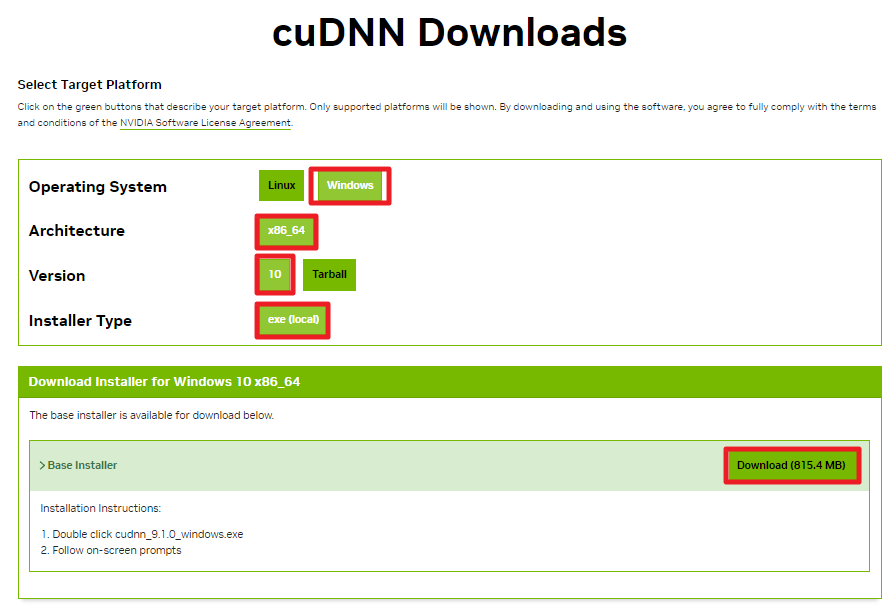

cuDNN 설치

cuDNN 다운로드 사이트에 접속한다. 다음과 같이 옵션 지정 후 다운로드 버튼을 클릭한다.

PyTorch 설치

CMD에서 파이토치를 설치한다. CUDA 버전은 위에서 설치한 CUDA의 버전으로 설정한다.

conda install pytorch torchvision torchaudio pytorch-cuda=12.1 -c pytorch -c nvidiaCUDA 사용 가능 여부를 확인한다.

import torch

print("CUDA Available:", torch.cuda.is_available())

print("CUDA Device Count:", torch.cuda.device_count())

if torch.cuda.is_available():

print("CUDA Device Name:", torch.cuda.get_device_name(0))